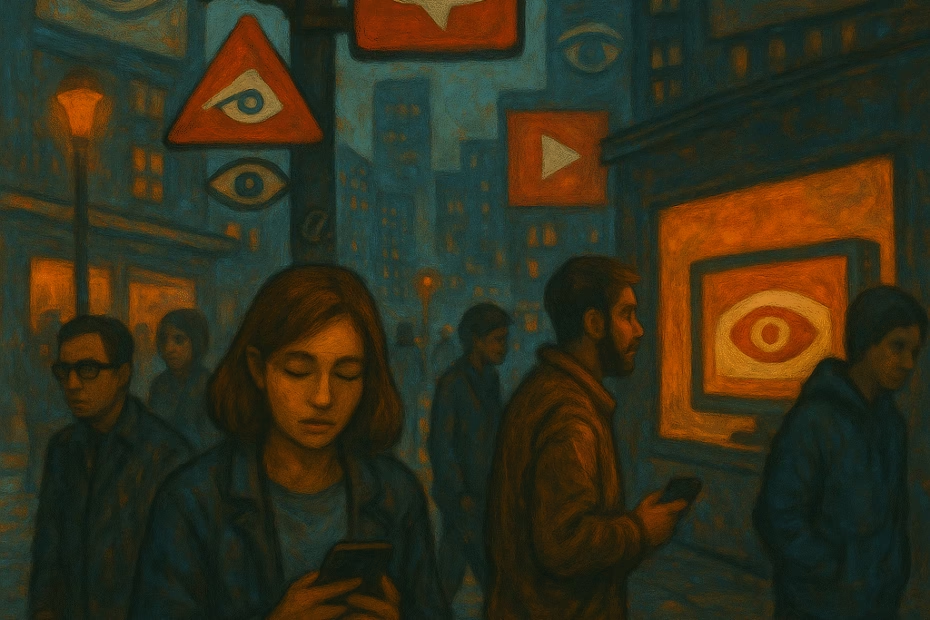

O olho que tudo vê

Vivemos em uma era em que quase tudo — do nosso trajeto diário ao tempo de tela — vira dado. A Quarta Revolução Industrial não apenas digitalizou a vida cotidiana; ela a transformou em matéria-prima para algoritmos. Cada movimento, escolha ou hesitação alimenta sistemas que não apenas observam, mas também antecipam nossas ações. As plataformas não querem apenas saber onde estamos — elas querem prever para onde vamos.

Esse processo de vigilância constante raramente se apresenta como opressão. Ao contrário: ele se disfarça de personalização, eficiência e comodidade. A experiência do usuário parece leve, fluida, sob medida. Mas por trás das telas e interfaces amigáveis, operam sistemas algorítmicos complexos — e opacos — que organizam o mundo segundo interesses econômicos concentrados e lógicas de dominação.

Essa lógica nos aproxima perigosamente da distopia imaginada por George Orwell em 1984. No romance, o poder absoluto não se sustenta apenas pela força, mas pelo controle contínuo da informação, da linguagem e do pensamento. O “Grande Irmão” não apenas observa: ele molda a realidade, redefine o sentido das palavras e elimina a possibilidade de dissenso.

De forma semelhante, o capitalismo de dados que estrutura a Quarta Revolução Industrial nos convida a aceitar a vigilância como algo natural. O maior perigo, como alertou Orwell, não está apenas em sermos observados — está em nos acostumarmos a ser observados, em não mais percebermos o controle como um problema. Quando isso acontece, a liberdade não desaparece de uma vez. Ela se esvazia, lentamente, sem barulho.

Neste artigo do Betaverso, vamos analisar como o capitalismo de dados reconfigura o controle social, discutir os limites da neutralidade algorítmica e refletir sobre os riscos de um futuro onde tudo é mensurável — menos a liberdade.

A matemática do poder

Ao contrário do senso comum, algoritmos não apenas organizam informações de forma neutra. Eles impõem critérios que jamais debatemos publicamente. Empresas e plataformas definem, sem consulta, quais dados importar, como interpretá-los e que decisões tomar a partir deles. Esses sistemas automatizados operam com base em modelos estatísticos que refletem escolhas humanas — e, muitas vezes, reforçam desigualdades.

Cathy O’Neil, em Armas de Destruição em Massa, denuncia com precisão esse cenário. Para ela, algoritmos se tornam perigosos justamente quando escondem seus parâmetros, não permitem auditoria e ignoram qualquer noção de justiça social. Em vez de promover equidade, esses sistemas consolidam privilégios.

Ao avaliar professores com algoritmos opacos, por exemplo, plataformas não apenas medem desempenho — elas moldam o que entendemos como “ensino de qualidade”. Ao filtrar currículos, analisar crédito ou sugerir ações policiais, algoritmos não apenas reproduzem preconceitos históricos. Eles os codificam em decisões que parecem técnicas, mas carregam forte carga ideológica.

O problema cresce quando aceitamos essas decisões sem questionamento. Ao tratarmos a matemática como sinônimo de verdade, atribuímos aos algoritmos um poder que eles não deveriam ter. Nesse processo, transformamos ferramentas em dispositivos de controle: silenciosos, automatizados e travestidos de neutralidade. Precisamos, portanto, encarar o controle algorítmico como um tema central da política contemporânea — e não apenas como um desafio técnico.

Vigilância como modelo de negócio

As grandes plataformas — Google, Meta, Amazon — não prestam serviços gratuitamente por altruísmo. Elas capturam o que fazemos, analisam nossos comportamentos e vendem previsibilidade. Transformam cada clique, busca ou deslize de dedo em perfis detalhados que alimentam sistemas de direcionamento, recomendação e influência.

Shoshana Zuboff chama isso de capitalismo de vigilância: um modelo que não só observa, mas antecipa e manipula. Ele lucra ao transformar nossas experiências mais íntimas em dados exploráveis. Não espera apenas que desejemos algo — sugere, induz, molda nossas escolhas antes mesmo de as reconhecermos como tais.

A cada permissão que concedemos sem ler, a cada app que instalamos por conveniência, cedemos um pouco mais da nossa autonomia. Em troca de serviços “gratuitos”, entregamos dados que nos tornam produto. Com o tempo, perdemos a capacidade de perceber o que realmente escolhemos — e o que foi escolhido por nós.

O perigo da despolitização

Apesar de parecerem naturais ou inevitáveis, as tecnologias que moldam nosso cotidiano resultam de decisões humanas — e, portanto, políticas. Alguém as desenhou, alguém escolheu seus critérios, alguém lucra com seus efeitos. Como enfatiza Evgeny Morozov, corremos um sério risco ao permitir que essas escolhas técnicas substituam o debate democrático. Quando tratamos questões sociais complexas como se fossem apenas falhas de design ou falta de dados, deslocamos o problema: tiramos das mãos da sociedade o direito de deliberar sobre seu próprio futuro.

Esse fenômeno tem nome: solucionismo tecnológico. Em vez de fortalecer a política, ele a enfraquece. Em vez de promover a participação, ele automatiza decisões. Ao transformar cidadania em interface, o solucionismo nos convida a aceitar termos de uso em vez de escrever constituições. A cada “atualização”, renunciamos a algum nível de controle — e, muitas vezes, nem percebemos.

Mais do que oferecer ferramentas, esse modelo impõe pacotes fechados. Apresenta algoritmos como respostas definitivas, como se fossem imparciais e indiscutíveis. O que se perde nesse processo é justamente o que a democracia tem de mais valioso: a possibilidade do dissenso, da disputa, da construção coletiva. Ao prometer eficiência, o solucionismo silencia a política. E, ao silenciar a política, compromete a própria ideia de liberdade.

Leia também: Capitalismo de Plataforma: O Novo Modo de Produção

Conclusão: é preciso desconfiar dos olhos que não piscam

A Quarta Revolução Industrial não gira apenas em torno de máquinas inteligentes ou avanços técnicos. Ela gira em torno de decisões humanas — sobre quem define os rumos, quem concentra os lucros e quem carrega os custos. Os dados que geramos todos os dias não são neutros nem inofensivos. Cada clique, cada passo, cada busca se transforma em matéria-prima para um sistema que extrai valor da nossa vida cotidiana — e, ao fazer isso, molda comportamentos, decisões e relações.

Por isso, mais do que nunca, precisamos questionar. Precisamos perguntar quem controla os dados, para que fins, com que limites. Porque, se não impusermos esses limites agora, corremos o risco de despertar em um mundo onde tudo — absolutamente tudo — será monitorado, previsto e otimizado. Tudo, exceto a liberdade.

Como nos alertou Orwell em 1984, talvez o maior perigo não seja o olhar constante do “Grande Irmão”, mas nossa capacidade de normalizar esse olhar. O verdadeiro risco está em aceitar a vigilância como conveniência, em trocar participação por personalização, em confundir eficiência com justiça.

Neste cenário, desconfiar dos olhos que não piscam é um ato de lucidez. Reivindicar o direito à dúvida, ao erro, ao anonimato — é também reivindicar o direito à democracia.

Leia o artigo anterior da série: A Nova Escola Digital: Personalização ou Padronização?

André Sampaio é historiador, educador e especialista em tecnologias aplicadas à educação. Com mais de 15 anos de atuação no setor, uniu sua experiência em sala de aula à inovação pedagógica, atuando como professor, autor de materiais didáticos e especialista pedagógico em edtechs.

Formado em História pela UFF e mestre em Educação pela PUC-Rio, com foco em tecnologias educacionais, é também colaborador do Betaverso — espaço onde escreve sobre os impactos da tecnologia na educação, cultura e sociedade. Sua trajetória é movida pelo compromisso com uma educação crítica, acessível e conectada com os desafios do presente.